Samsungs Verkaufsstrategie für TV-Verkäufe im Jahr 2020 ist einfach: 8,000 oder weniger. Während die Verkaufszahlen der QLED-Budget-4K-Fernseher von preisgünstigen 4K-Fernsehern nicht ausreichend genutzt werden, plant Samsung, den Markt erneut auf ein Format umzustellen, das (bisher) nur sehr wenige Konkurrenten, aber auch sehr wenig native Inhalte hat.

Wie wir jedoch in unserem 4K vs. 8K Anfang dieses Jahres benötigten Sie eigentlich kein Videomaterial mit einer Auflösung von 780 x 4320 (8K), um mit diesen Millionen Pixeln aufzunehmen: Samsung 8K-Fernseher nutzen die Aufwärtskonvertierung, um jedes Bild zu konvertieren. Videotyp (SD bis 4K und alles dazwischen) in 8K-Auflösung.

Natürlich ist der Pegelanstieg nicht neu. Seit Jahren finden 4K- und sogar HD-Fernseher Möglichkeiten, Inhalte mit niedriger Auflösung zu strecken, um sie an das höhere Pixel/Zoll-Verhältnis moderner Fernseher anzupassen. Da 8K-Fernseher jedoch vier 4K-Pixel belegen müssen, funktionieren herkömmliche Aufwärtskonvertierungsmethoden aus Gründen, auf die wir später noch eingehen, einfach nicht.

Nachdem wir nun die Qualitätskontrolllabore von Samsung in New Jersey besucht und mit den Ingenieuren gesprochen haben, haben wir eine bessere Vorstellung davon, wie Samsung künstliche Intelligenz und maschinelles Lernen nutzt, um es so aussehen zu lassen. Ist es möglich, 8K hochzuskalieren, und wie sind die KI-Techniken im Vergleich zu denen der frühen Bemühungen der Hersteller?

Warum sah die konventionelle Verbesserung so schrecklich aus?

Vor 1998 hatten Fernsehsendungen eine Auflösung von 720 x 480, und in höherer Qualität aufgenommene Filme wurden komprimiert, um in dieses Format zu passen. Das sind 345,600 Pixel an Inhalten, die auf modernen Fernsehern mit höheren PPI-Verhältnissen (Pixel pro Zoll) nur ein kleines Fenster einnehmen würden. Dieser SD-Inhalt? Es muss erweitert werden, um mehr als 2 Millionen Pixel in High Definition abzudecken, mehr als 8 Millionen für 4K oder mehr als 33 Millionen für 8K.

Die Grundlage für die Skalierung besteht darin, mithilfe einer einfachen Multiplikation das korrekte Pixelverhältnis beizubehalten. Um HD in 4K umzuwandeln, muss der Prozessor des Fernsehers ein HD-Pixel ausnutzen, um vier Pixel Platz auf dem Bildschirm mit höherer Auflösung einzunehmen. Oder 16 Pixel bei der Konvertierung von HD-8K.

(Bildnachweis: Sony)

Ohne jegliche Bildbearbeitung war das Bild, um Tolkien zu zitieren, „irgendwie gedehnt, wie Butter, die von zu viel Brot abgekratzt wurde“. Jedes Datenelement wird ungewöhnlich quadratisch, ohne natürlichen Farbverlauf zwischen Details und Farben. Dies führt zu großen Blockaden oder Geräuschen um Objekte auf dem Bildschirm herum.

Sie werden wahrscheinlich auch etwas sehen, das „Mückenlärm“ genannt wird. Um ein Video so zu komprimieren, dass es mit Ihrer begrenzten Internetbandbreite funktioniert, müssen Sender und Websites den Fluss absichtlicher Farbfehler oder „Komprimierungsartefakte“ vervollständigen. Bewusst schlechte Pixel wimmeln in Bereichen des Bildschirms, in denen es starke Kontraste gibt, wie etwa die braune Brücke vor dem blauen Himmel im Bild oben.

Die Mathematik hinter der Luxusbewegung

Angesichts dieser Probleme haben Fernsehprogrammierer ihren Fernsehern beigebracht, Bilder in Echtzeit digital zu analysieren und zu verarbeiten, um fehlende oder beschädigte Pixel zu ergänzen oder zu reparieren. Und das erreichten sie durch den Einsatz mathematischer Funktionen, die Sie Ihren Lieben mitteilen können, wenn sie das nächste Mal sagen, dass zu viele Fernseher Ihr Gehirn ruinieren.

Konkret brachten die Ingenieure dem Fernsehprozessor bei, den Farbwert jedes fehlenden Pixels basierend auf den umgebenden Pixeln zu interpolieren. Dazu musste er seinen Kernel definieren: die Funktion, die den Nachbarn eines Pixels entsprechend ihrer Nähe eine Farbpriorität zuweist.

Der grundlegendste Kernel, der in Fernsehgeräten verwendet wird, ist der nächstgelegene Kernel, der einfach berechnet, welches Pixel einem leeren Pixel am nächsten liegt, und die gleichen Farbdaten in das leere Pixel einfügt. Diese Methode führt dazu, dass das Bild ein blockartiges Zick-Zack-Muster oder Aliasing mit einer schwachen Kante annimmt. Stellen Sie sich einen schwarzen Buchstaben „A“ auf einem weißen Bildschirm vor; Ein fehlendes Pixel direkt außerhalb des Buchstabens wird möglicherweise schwarz ausgefüllt, während ein Pixel am Rand des Buchstabens möglicherweise weiß erscheint. Das Ergebnis ist ein grauer Fleck um den Buchstaben herum oder eine unregelmäßige schwarz-weiße Treppe, die auf und ab führt.

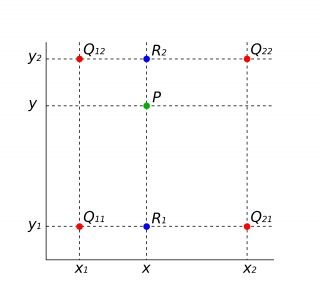

Dieses Diagramm zeigt den Berechnungsprozess für ein leeres Pixel (den grünen „P“-Punkt) basierend auf bilinearer Interpolation.

(Bildnachweis: gemeinfrei)

Die bilineare Interpolation erfordert mehr Rechenleistung, ist aber effizienter. Bei dieser Methode wird das leere Pixel mit den beiden nächsten Nachbarn verglichen, um einen linearen Gradienten zwischen ihnen zu bilden und so die Schärfe des Bildes zu verbessern. Dies führt zu weicheren visuellen Effekten, kann jedoch inkonsistent sein. Daher verwenden andere Fernseher die bikubische Interpolation, die auf die nächsten 16 Pixel in alle Richtungen schießt. Obwohl diese Methode eine möglichst präzise Farbwiedergabe ermöglicht, erzeugt sie auch ein viel diffuseres Bild, wobei die Umrisse einen störenden Halo-Effekt bekommen.

Sie können das Problem wahrscheinlich inzwischen erraten: Diese Fernseher füllen Pixel auf der Grundlage mathematischer Formeln aus, die statistisch gesehen mit größerer Wahrscheinlichkeit genaue Bilder erzeugen, haben aber keine Möglichkeit, ihr thematisches Erscheinungsbild entsprechend dem, was tatsächlich auf dem Bildschirm angezeigt wird, zu interpretieren.

Nachdem das Samsung-Team erklärt hatte, dass diese Algorithmen durchweg erfolglos waren, erläuterte es, wie die künstliche Intelligenz diese Nachteile überwindet.

Samsungs Geheimnis: maschinelles Lernen, Objekterkennung und Filter

(Bildnachweis: Samsung)

Samsungs Geheimwaffe ist eine Technik namens Machine Learning Super Resolution (MLSR). Dieses KI-gestützte System nimmt einen Videostream mit niedrigerer Auflösung und passt seine Größe an die Auflösung eines größeren Bildschirms mit einem höheren PPI-Verhältnis an. Es ist das alte Gegenstück zum Informatiker, der einfach auf eine Taste drückt und ein verschwommenes Bild „verbessert“, allerdings geschieht dies automatisch und fast augenblicklich.

Vertreter von Samsung erklärten, wie sie eine große Menge an Videoinhalten aus verschiedenen Quellen (hochwertige und minderwertige YouTube-Quellen, DVDs und Blu-Rays, Filme und Sportereignisse) analysiert und zwei Datenbanken erstellt haben. Bilder, eines für die schlechten Screenshots und eines für die qualitativ hochwertigen Screenshots.

Anschließend musste er seine KI trainieren, um einen Prozess durchzuführen, der vom KI-Sektor als „Reverse Downgrade“ bezeichnet wird. Zunächst werden hochauflösende Bilder aufgenommen und auf niedrigere Auflösungen herabgestuft, um verlorene visuelle Daten aufzuspüren. Anschließend müssen Sie den Vorgang umkehren und Ihre KI trainieren, um die fehlenden Daten aus den Bildern mit niedriger Auflösung zu ergänzen, damit sie die Bilder mit hoher Auflösung widerspiegeln.

Das Samsung-Team nennt diesen Prozess eine „Formel“. Seine 8K-Renderer enthalten eine Formelbank mit einer Datenbank mit Formeln für verschiedene Objekte, wie einen Apfel oder den Buchstaben „A“. Wenn der Renderer einen verschwommenen Apfel in der Hand eines Schauspielers erkennt, stellt er die Ränder des Apfels wieder her, behebt Komprimierungsartefakte und stellt sicher, dass weiße Pixel basierend auf der Farbe den richtigen Rotton annehmen. Aussehen von Äpfeln und nicht auf vagen statistischen Algorithmen. . Außerdem stellt die KI nicht nur bestimmte Objekte wieder her, sondern passt Ihren Stream auch an das an, was Sie sehen.

Laut Samsung gibt es Dutzende verschiedener „Filter“, die den Grad der Detailerstellung, Rauschunterdrückung und Kantenwiederherstellung für einen bestimmten Stream ändern, je nachdem, ob Sie eine Sportart, ein Filmgenre oder eine Filmart ansehen. Kinematographie.

Bild 1 von 5

(Bildnachweis: Michael Hicks)

Klettern in Aktion

Bild 2 von 5

(Bildnachweis: Michael Hicks)

Bild 3 von 5

(Bildnachweis: Michael Hicks)

Bild 4 von 5

(Bildnachweis: Michael Hicks)

Bild 5 von 5

(Bildnachweis: Michael Hicks)

Laut Samsung-Ingenieuren ist die Wiederherstellung der in der vorherigen Diashow dargestellten Konturen – eine unglaubliche Textmenge, die in Echtzeit wiederhergestellt werden muss – nicht einmal die schwierigste Aufgabe für künstliche Intelligenz. Stattdessen bleibt es eine schwierige Herausforderung, die richtigen Texturen eines Objekts in Echtzeit zu reproduzieren. Sie müssen sicherstellen, dass der Renderer das Erscheinungsbild der Objekte verbessert, ohne sie unnatürlich zu machen.

Was der Prozessor (laut Samsung) nicht tun wird, ist, ein Objekt falsch zu klassifizieren. „Aus einem Apfel wird keine Tomate“, versicherte uns ein Ingenieur, ohne jedoch näher darauf einzugehen. Höchstwahrscheinlich ist der Prozessor darauf trainiert, radikale Änderungen zu vermeiden, wenn er nicht erkennt, was ein Objekt ist.

Wie das Samsung-Team sagte, wird künstliche Intelligenz die Absichten des Filmemachers nicht verändern. Wenn ein Regisseur also den Bokeh-Effekt nutzt, bleibt der unscharfe Hintergrund unscharf, während der Vordergrund bis zu 8K scharf zusammengesetzt wird.

Sie gaben außerdem an, dass sie sich bei der Objektkategorisierung nicht speziell auf die beliebtesten Feeds konzentrierten, sondern sich stattdessen mehr auf die Gesamtmenge und Vielfalt der Inhalte konzentrierten. Es ist also nicht bekannt, ob sie eine „Drachen“- oder „Werwolf“-Formel für ihre hektischen „Game of Thrones“-Uhren haben.

Die neueste Reihe von QLED-Fernsehern

(Bildnachweis: Michael Hicks)

Auf neuen 8K- (und 4K-)Fernsehern von Samsung ist die neueste Formelbank installiert, und dann werden neue Objektdaten über Firmware-Updates hinzugefügt, die Sie genehmigen müssen. Samsung gibt an, weiterhin neue visuelle Streams zu testen, um seine Objektbibliothek zu erweitern, tut dies jedoch lokal auf Samsung-Servern. analysiert keine Daten von persönlichen Fernsehgeräten.

Wie viele Samsung-Artikelformeln haben Sie durch Ihre endlose Stream-Analyse gesammelt? Einer ihrer Ingenieure gab eine unglaubliche Momentaufnahmemenge an, die darauf hindeutete, dass der Prozessor im Allgemeinen eine große Anzahl von Objekten auf dem Bildschirm erkennen würde. Aber ein PR-Mitarbeiter intervenierte und bat uns, die Zahl nicht zu drucken, mit der Begründung, dass es den Verbrauchern lieber sei, sich auf die Leistungsqualität des Samsung MLSR zu konzentrieren, als auf willkürliche Zahlen.

KI-Verbesserung: die neue Normalität?

Samsung ist nicht der einzige TV-Hersteller, der derzeit künstliche Intelligenz und Bildwiederherstellung für seine Fernseher einsetzt.

Die 4K-Werbeseite von Sony enthält beunruhigende Details zu seinen KI-Bildverarbeitungslösungen. Seine neuen 4K-Fernseher enthalten Prozessoren mit einer „doppelten Datenbank“ von „Zehntausenden“ Bildreferenzen, „die Pixel in Echtzeit dynamisch verbessern“.

(Bildnachweis: Sony)

Im Vorfeld der CES 2019 kündigte LG außerdem an, dass sein neuer TV-Chip a9 Gen 2 Bildverarbeitung und maschinelles Lernen umfassen werde, um die Rausch- und Helligkeitsreduzierung zu verbessern, unter anderem durch die Analyse der Quelle und des Medientyps und die entsprechende Anpassung seines Algorithmus.

Abgesehen von den KI-Elementen scheinen diese TV-Prozessoren jedoch immer noch in gewissem Maße auf automatisierten Algorithmen zu basieren. In unserem früheren Interview mit Gavin McCarron, Leiter für technisches Marketing und Produktplanung bei Sony Europe, über die KI-Bildverarbeitung in Sony-Fernsehern hatte er Folgendes zu sagen:

„Wenn man von Full HD auf 4K umsteigt, gibt es viele Rätselraten, und wir versuchen, so viele Rätselraten wie möglich zu vermeiden. (Unser Prozessor) berücksichtigt nicht nur die Pixelisolation, sondern auch die Pixel um ihn herum und auf jeder Diagonale und sucht auch nach Pixeln über mehrere Frames hinweg, um eine konsistente Bildqualität zu gewährleisten.“

Es ist sehr wahrscheinlich, dass Sony sowie LG und Samsung eine Art bilateralen oder bikubischen Algorithmus als Aufwärtskonvertierungssystem verwenden. Anschließend analysieren sie nahezu 4K-Inhalte und bestimmen, welche Pixel durch Bildverarbeitung verstärkt und welche als Rauschen entfernt werden sollten.

In diesem Sinne liegen die meisten TV-Hersteller im Rennen um Spitzen-KI relativ nah beieinander. Die Ausnahme bildet Samsung, das die gleichen Techniken verwendet, aber die vierfache Anzahl fehlender Pixel auffüllt, um auf ein 8K-Display zu passen. Wir müssen abwarten, ob die KI-Bemühungen anderer Hersteller es ihnen auch ermöglichen, in den 8K-Markt einzusteigen.