- Der Vergleich

- Tutorials

- Das Nvidia Mellanox InfiniBand der nächsten Generation wird Supercomputer auf die nächste Stufe heben

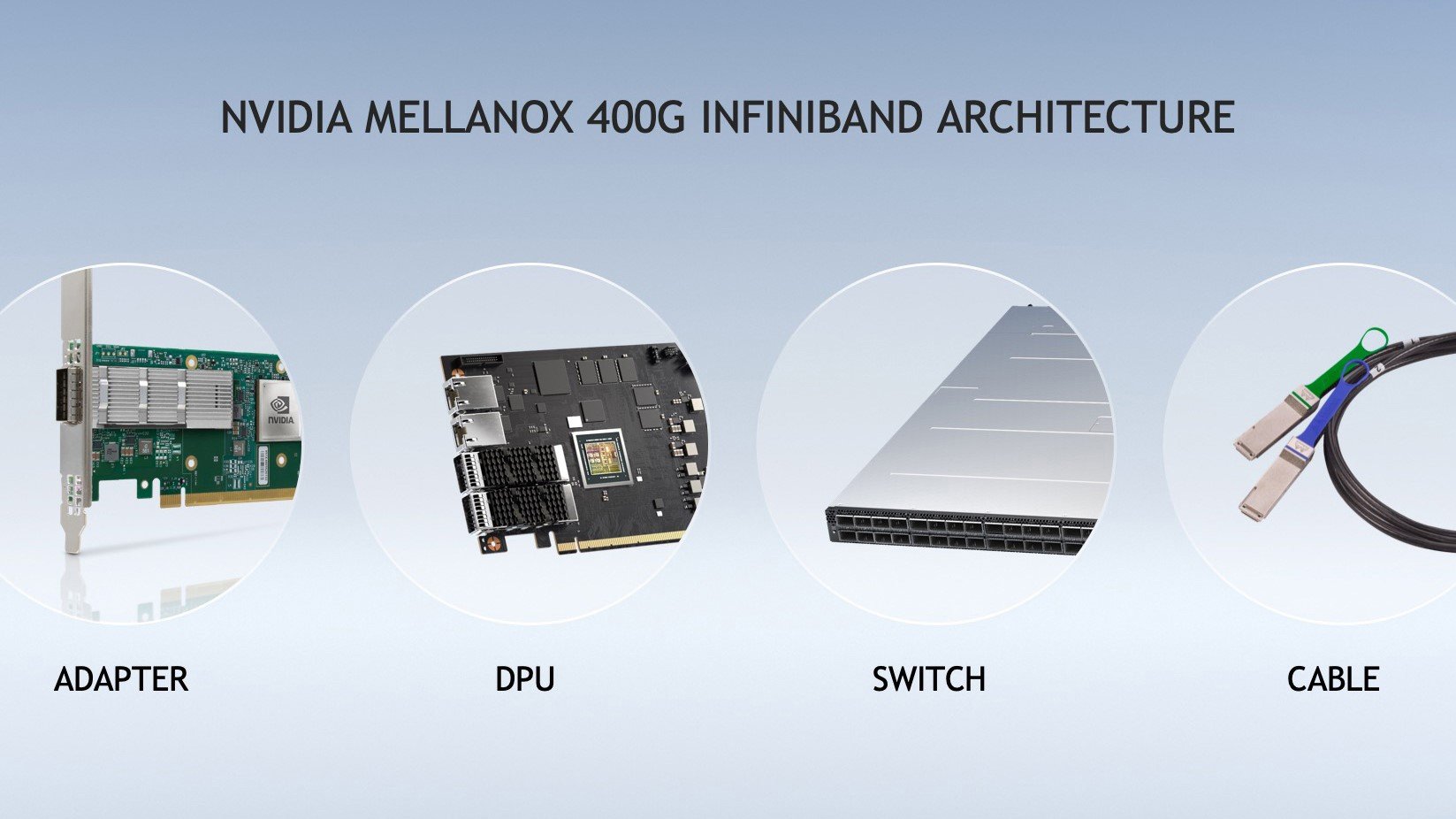

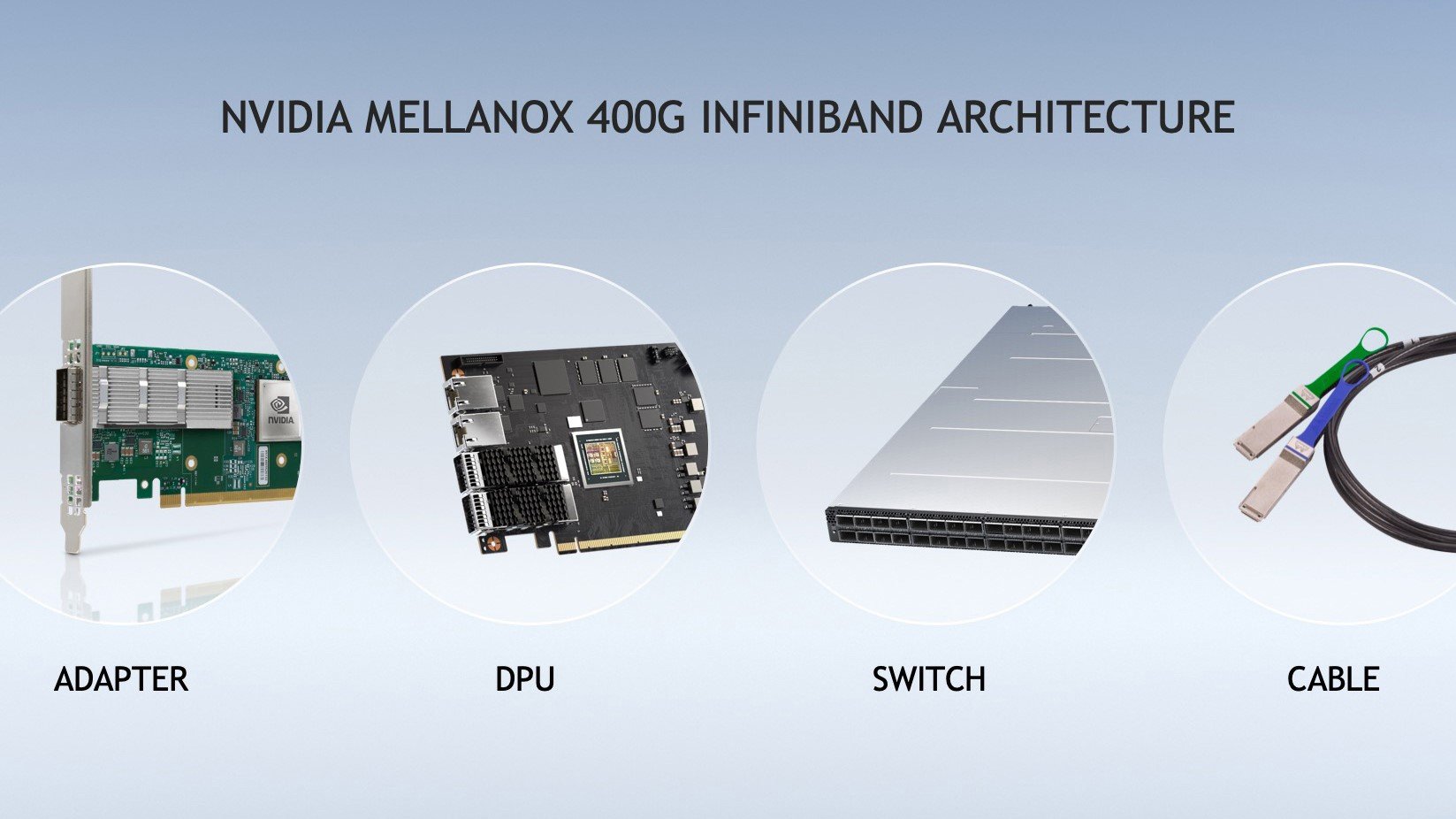

Um KI-Entwicklern und wissenschaftlichen Forschern die schnellste verfügbare Netzwerkleistung auf ihren Workstations zu bieten, stellte Nvidia die nächste Generation seines Nvidia Mellanox 400G InfiniBand vor. Nvidia Mellanox 400G InfinBand beschleunigt die Arbeit in Bereichen wie Arzneimittelentdeckung, Klimaforschung und Genomik mit einem dramatischen Leistungssprung, der auf der weltweit einzigen vollständig entlasteten Netzwerk-Computing-Plattform erzielt wird. Die siebte Generation von Mellanox InfiniBand bietet Benutzern extrem niedrige Latenzzeiten und verdoppelt den Datendurchsatz mit 400 Gbit/s NDR, während sie mit neuen Nvidia-Netzwerk-Rechen-Engines für zusätzliche Beschleunigung sorgt. Die weltweit führenden Infrastrukturhersteller, darunter Atos, Dell Technologies, Fujitsu, Gigabyte, Inspur, Lenovo und Supermicro, planen die Integration von Nvidia Mellanox 400G InfiniBand in ihre bestehenden Geschäftslösungen und HPC-Angebote. Gleichzeitig bieten auch große Speicherinfrastrukturpartner wie DDN und IBM Storage umfassenden Support an.

Nvidia Mellanox 400G InfiniBand

Die neueste Ankündigung von Nvidia baut auf der Weiterentwicklung des Mellanox InfiniBand als branchenweit robusteste Lösung für KI-Supercomputing auf. Das Nvidia Mellanox 400G InfiniBand bietet die dreifache Portdichte des Switches und wächst um das 32-fache. die beschleunigende Kraft der KI. Darüber hinaus erhöht es die bidirektionale Gesamtleistung des Vermittlungssystems um das Fünffache auf 1,64 Petabits pro Sekunde, sodass Benutzer größere Arbeitslasten mit weniger Stress ausführen können. Da Offload-Vorgänge für KI-Workloads von entscheidender Bedeutung sind, ermöglicht die Nvidia Mellanox Sharp-Technologie der 32. Generation die Auslagerung und Beschleunigung von Deep-Learning-Trainingsvorgängen über das InfiniBand-Netzwerk, was zu einer 400-fach höheren KI-Beschleunigung führt. Durch die Kombination des Nvidia Magnum IO-Software-Stacks mit dem Nvidia Mellanox 51,2G InfiniBand können KI-Entwickler und -Forscher sofort von beschleunigtem wissenschaftlichem Rechnen profitieren. Edge-Switches, die auf der Mellanox InfiniBand-Architektur basieren, sind in der Lage, einen aggregierten bidirektionalen Durchsatz von 6.650 TB/s mit einer Kapazität von mehr als 1,64 Milliarden Paketen pro Sekunde zu übertragen. Mellanox InfiniBand-basierte modulare Switches hingegen können einen bidirektionalen Gesamtdurchsatz von bis zu 400 Petabits pro Sekunde übertragen, was fünfmal höher ist als bei der letzten Generation. Gilad Shainer, Senior Vice President of Networking bei Nvidia, erklärte in einer Pressemitteilung, wie das Nvidia Mellanox 400G InfiniBand KI-Entwicklern und -Forschern bei der Bewältigung immer komplexerer Anwendungen helfen kann: „Die wichtigste Arbeit unserer Kunden basiert auf künstlicher Intelligenz und immer komplexer werdenden Anwendungen, die die Anforderungen erfüllen.“ schnellere, intelligentere und skalierbarere Netzwerke. Die enorme Leistung und die intelligenten Beschleunigungs-Engines von NVIDIA Mellanox XNUMXG InfiniBand ermöglichen HPC-, KI- und Hyperscale-Cloud-Infrastrukturen, unübertroffene Leistung bei geringeren Kosten und geringerer Komplexität zu erreichen. "